词嵌入word2vec

28 Oct 2018 | NLP |word2vec作为神经概率语言模型的输入,是为了通过神经网络学习某个语言模型而产生的中间结果。具体来说,“某个语言模型”指的是CBOW和Skip-gram。具体学习过程会用到两个降低复杂度的近似方法——Hierarchical Softmax或Negative Sampling。两个模型乘以两种方法,一共有四种实现。

下面是手写版本的推导

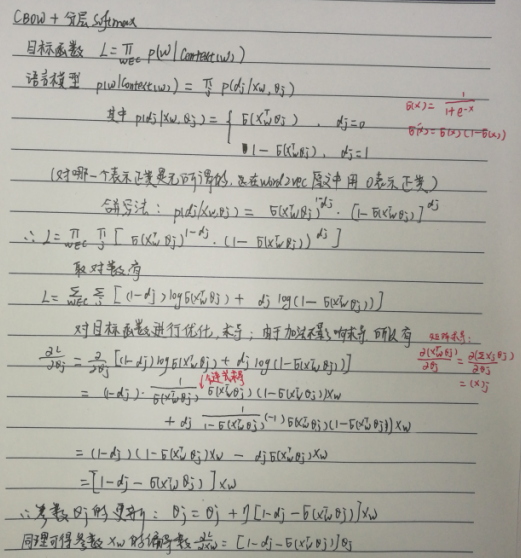

CBOW + Hierarchical Softmax

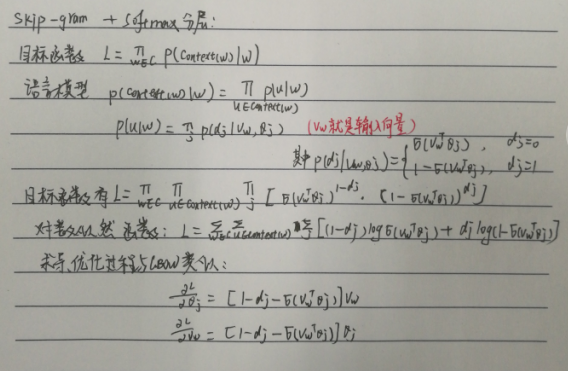

Skip-gram + Hierarchical Softmax

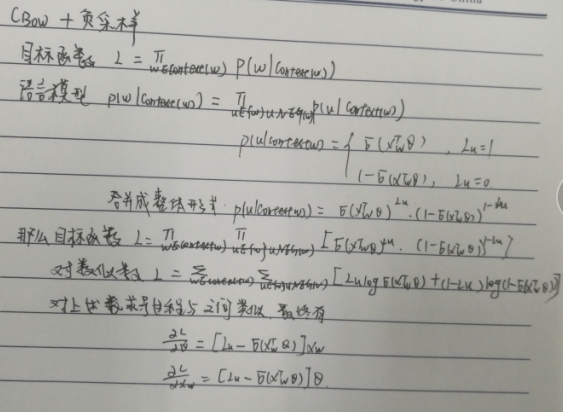

CBOW + Negative Sampling

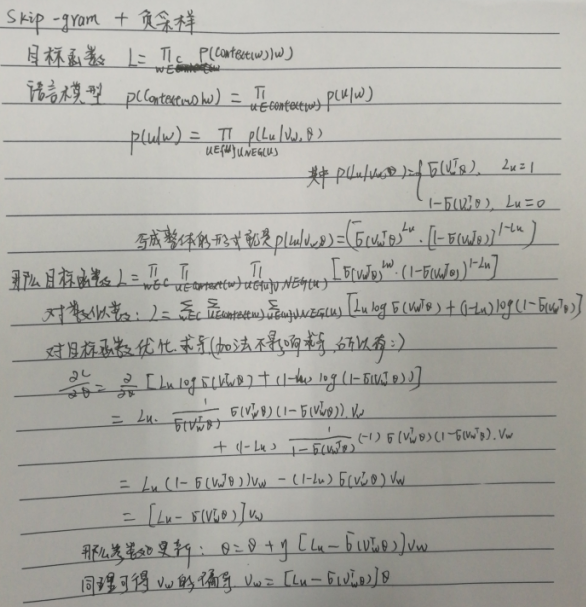

Skip-gram + Negative Sampling